Изкуственият интелект може да удължи живота ни драстично, а и да го направи по-хубав по толкова много начини. За това сме ви разказвали немалко Дигитални истории и още много ви очакват. Вярвам, че един ден той може да замени (или поне да допълни или подпомогне) журналистите, програмистите, дори политиците. Помага ни да прогнозираме пандемията. Напоследък обаче това словосъчетание се използва толкова безогледно и маркетингово, че наистина си струва винаги, когато го чуем, да имаме едно наум.

Колкото по-нашумяла е една област от познанието, толкова по-привлекателна става и за измами, питайте Остап Бендер. От кръвопускането и пиявиците до нанотехнологиите, много е яко да сложиш пелерината на ултрамодерната технология и да избиеш рибата. Понякога прекалено буквално.

Да, безобидно, макар и малко наивно е да слагаме етикета на всичко, търсейки евтина слава. Да, няма нужда черпакът за шкембе чорба да е с изкуствен интелект. И това е немалка част от проблема – заради безогледното ползване на този термин, това руши реномето и на сериозните проекти.

По-лошо обаче става, когато става дума за особено чувствителни области, като например медицината. ИИ днес е навлязъл в много нейни области… Но какво се случва, когато технологията, на която сме се предоверили, започне да не изпълнява задачите си? И пропусне най-важната част от хипократова клетва: Primum non nocere. „Преди всичко, не вреди…“

Проф. Гари по безпътните гари

Проф. Гари Н. Смит е от малкото учени, които се опитват да привличат вниманието именно към подобни теми. Той се занимава с изкуствен интелект, с икономика, автор е на 3 книги, излезли под марката на издателството на „Оксфорд“. Основният лайтмотив в работата му е да ни предупреждава: ИИ идва, за да промени живота ни. Но ако се предоверяваме на всичко, което се скрие зад атрактивното му название, ще страдаме. За „9 клопки в науката за данните“ той дори печели наградата на Американската асоциация на издателите за популярна наука.

Тук например той дава един особено показателен пример.

„Епик системс“ е най-голямата компания в Америка, която се занимава с обработване на данните за здравословното състояние на хората. Това е, най-меко казано, внушително постижение – знаете колко сериозни са регулациите за съхранението и анализа на лични данни, а какво остава за най-уязвимата информация, тази, свързана със здравето!

И на този фон, „Епик“ официално и направо епично имат достъпа до данните на 180 милиона души, цели 56% от американците!

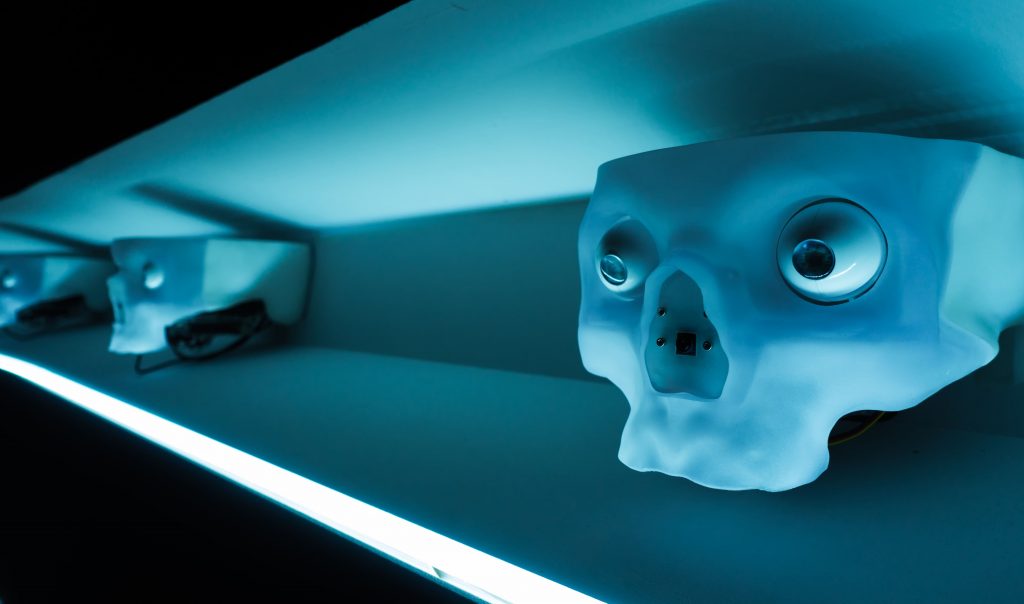

„С пациента в сърцето“, гласи силно емоционално подбраният слоган на компанията. В портфолиото ѝ има 20 изпипани алгоритъма, базирани на изкуствения интелект, чиято цел е да предскажат, потвърдят дадена диагноза, или да предположат за колко дни ще бъде хоспитализиран определен пациент.

Снимка: Alessio Ferretti, Unsplash

Гаргари и алгоритми

Както отбелязва проф. Гари Смит, прекалено често се случва да чуем, че нещо е дело на съвременната магия „изкуствен интелект“. И, понеже е „търговска тайна“, „патент за милиони“ или каквато и да е друга безценност, не е ясно какво точно се случва в черната кутия на алгоритъма. Нито е възможно да се правят някакви елементарни проверки с конкретни външни данни.

Едно от основните призвания на епичния „Епик“ е да предсказва случаите на сепсис, внезапна инфекция, водещата причина за смъртност в болниците. Както пише проф. Смит, „сепсисът се получава, когато човешкото тяло реагира прекалено бурно на инфекцията и изпраща в кръвообращението вещества, които могат да разрушават тъканите или да пречат да органите да функционират нормално. Ранното диагностициране буквално може да спасява животи, но… сепсисът е много трудно да бъде диагностициран рано“.

И така, „Епик“ има особено перспективен алгоритъм, базиран на изкуствения интелект, който казва, че може да предскаже с точност между 73 и 84% опасността от сепсис!

Страхотно, нали? Толкова много спасени животи!

Само че съвсем неотдавна, в първия ден на август, в реномираното издание „JAMA, вътрешна медицина“ бяха публикувани прелюбопитни данни на екип от изследователи, проучили болничните данни на 38 455 пациенти, преминали през Университетската болница на Мичиган. 6,6% от тях, или 2552-ма, наистина развили сепсис. Как обаче се е справила системата, която е трябвало да предскаже дали ще се стигне до проблем?

Следващата елементарна табличка казва всичко. Отгоре с „Епик+“ и „Епик-“ са отбелязани прогнозите на алгоритъма дали при даден пациент ще се развие сепсис, а отдолу е реалният резултат.

| Епик+ | Епик- | Общо | |

| Развили | 843 | 1709 | 2552 |

| Не развили | 6128 | 29 775 | 35 903 |

| Общо | 6971 | 31 484 | 38 455 |

Грешка не човешка

Проба, грешка. Цифрите май и сами показват колко далеч се е оказал алгоритъмът от истината.

Но все пак проф. Гари Смит откроява две основни зависимости:

– От 2552 пациенти със сепсис системата е генерирала предупреждение само за 843, което е едва 1/3.

– От 6971 предупреждения прогнозата се е потвърдила само при… 843 души. Дванайсет процента!

Погледнато наобратно: системата се е провалила при откриването на 67% от случаите, а от дадените предупреждения 88% са се оказали неточни.

Тоест, дори ако просто седите и хвърляте монета, процентът на познатите случаи може би ще се окаже доста по-точен.

А сега си представете, че наистина от този алгоритъм, за който са похарчени огромни суми, не просто се очаква да предупреждава, а по някакъв начин от него директно зависи здравето на пациентите… Направо плашещо, нали?

Снимка:Maxim Hopman, Unsplash

Епично

Проф. Смит отбелязва също, че много от другите системи, развивани от „Епик системс“, всъщност са много, много по-неубедителни в прогнозите си, отколкото е заложено в обещанията. И изследователят предупреждава, че определено не е добра идея да се дава достъп до огромна здравна информация с мултимилиардни проекти на уж базирани на изкуствения интелект решения. Които обаче в действителност се оказват много, много по-нескопосани от лустросаната си обвивка.

Редно е подобни системи да бъдат тествани и оценявани по-внимателно от учените, преди да се въведат в практиката. При това от независими екипи. А не просто да имаме една черна кутия, която приема някакви данни и „изплюва“ резултат.

Проблемът, разбира се, съвсем не се изчерпва с една фирма.

Д-р Уотсън в бюрото по труда

Все още в сферата на медицината, струва си да споменем и проекта „Д-р Уотсън“. Да, това е начинание на IBM, базиращо се на същия този суперкомпютър „Уотсън“, който не спря да побеждава хората в разни състезания. Тук обаче изгуби.

Една от идеите на създателите му беше да го вкарат в медицината. Отне 5 години и 60 милиона долара за разработка, преди „д-р Уотсън“ да бъде „уволнен“ от центъра за лечение на онкологични заболявания „Андерсън“ в Хюстън, заради „многобройни примери за небезопасни и неправилни препоръки за лечение“.

И последен медицински пример. В реномираното списание „Нейчър“ през март тази година бе публикуван сравнителен анализ на 2212 различни публикации, използващи модели за машинно самообучение в опит да предсказват или да диагностицират развитието на ситуацията с коронавируса.

Резултатът: „Нито един от моделите не показва потенциал за евентуално прилагане в клинични условия“.

Груботи

Немалко ИИ проекти пък се провалят доста зрелищно, дори комично. Пословичен е примерът с чатбота Тай, многообещаващ проект на „Майкрософт“ от 2016-а за технология, която управлява туитър акаунт с идеята да води разговори досущ като типичен американски младеж.

Е, не знаем какво е типичното за повечето младежи, но Кай доста бързо показва силно плашещи страни от характера си. Няколко часа след пускането на проекта вече заявява, че ненавижда евреите, а Хитлер е бил прав. Чатботът е спрян по-малко от денонощие след старта на проекта. Става ясно, че зложелателни потребители на мрежата са използвали слабости в начина, по който алгоритъмът се учи, за да го накарат да приказва като расист и човекомразец.

Ще кажете – тази история е вече доста стара. Да, но пък е показателна и ни кара да се замисляме. Ами ако по същия начин може да се манипулира например ИИ, който отговаря за управлението на автономните коли?

Депутати и престъпници

Всички сме слушали за съвършените системи за лицево разпознаване в Китай (макар че по въпроса наистина има повече от една гледна точка). Е, през 2018-а полицията арестува погрешка съпругата на един от най-богатите хора в страната, защото ИИ грешно я припознал за шофьорка, виновна за много сериозна катастрофа. Нещо повече, лицето ѝ се появява на гигантските екрани, на които публично се показват най-сериозните нарушители на правилата като форма на публично порицание.

Подобен проблем имат и от „Амазон“. Журналистически експеримент показва, че системата им за лицево разпознаване бърка 28 от членовете на американския конгрес с криминални престъпници. Нещо повече – алгоритъмът асоциира 40% от хората на снимките с афроамериканци, макар в действителност такива да са под 20% от конгресмените.

Завършваме списъка с малко прогностика. Преди последното световно първенство по футбол какви ли не ентусиасти се опитват да прогнозират победителя с помощта на всякакви модели и алгоритми. Накрая резултатите им са обобщени. Бразилия, сочена като победител в най-много от моделите, стигна до четвъртфиналите. А другите два най-вероятно победители – Испания и Германия, отпаднаха дори по-рано.

За да не прекаляваме с песимизма, ето и един пример, когато ИИ си върши работата чудесно, но… това води до сериозни проблеми. Главният финансист на базирана в Англия енергийна компания превежда 220 000 евро на унгарски доставчик. Просто си изпълнява задълженията, защото му се е обадил и му е казал за го направи самият германец, главен шеф на фирмата. После обаче се оказва, че това е бил звуков вариант на технологията дийп фейк, при който изкуственият интелект точно е наподобил гласа на шефа. „Звучеше с абсолютно същия немски акцент и същата мелодика в гласа“, разказва жертвата пред „Уолстрийт Джърнъл“.

Снимка: Arseny Togulev, Unsplash

Алгоритме, алгоритме…

Както предупреждава в друга своя статия проф. Смит, с когото започнахме, изкуственият интелект се е превърнал в мантра, в маркетингово клише, в хайп, както биха казали по-младите.

Той ни разказва и историята на Джъстин Уонг, който завършва с добри оценки бакалавър и магистратура по информационни технологии и през 2017-а създава базираната в Сингапур компания на име „Скрай“. Целта ѝ е да се превърне в „платформа за социални предсказания“. Потребителите се регистрират безплатно и могат да въвеждат своите собствени прогнози за вероятността за дадено събитие. Кой ще е следващият президент на САЩ? Ще успее ли Мъск да „откара“ хора на Марс в близкото десетилетие. Използва се принцип, познат като „мъдростта на тълпата“, за който вече сме разказвали в комплект с блокчейн технологията.

Скоро той прави и следващата стъпка – „Скай Вентидж“, система, която прави същите тези прогнози. Само че с помощта на алгоритъм, който, разбира се, също е заключен в черна кутия. И всяка прогноза, направена с него, вече струва по 400 долара.

„Наричаме го ИИ, само това ви трябва да знаете“, е принципът, на който работят доста такива проекти. Но дали зад тях наистина се крие сериозен, научно обоснован и проверен алгоритъм? Или просто си играем на онче-бонче и търсим отговора в гугъл?

Алго-ритни ме!

Всъщност, проф. Смит слага в списъка с подобни проекти и GPT-3, което със сигурност е доста по-спорно. Тази технология наистина изглежда доста обещаваща, в крайна сметка всички можем да я проверим днес по доста различни начини.

Още една причина да сме по-мнителни, чуем ли „мантрата“ ИИ, ни дава това проучване от 2019-а. Според данните на една от водещите компании в тази сфера – „Пактера технолоджис“, цели 85% от проектите за разработване на изкуствен интелект в различни области се провалят. Те така и не успяват да доставят това, за което са създадени. Процентът наистина е много сериозен, като изследователите дават доста възможни обяснения. От една страна – трудното адаптиране към толкова сериозни промени, от друга – прекалено амбициозните задачи, които се поставят, при положение, че очевидно тази технология има още много да се развива, преди да предложи дори част от впечатляващите неща, които очакваме от нея.

Изкуственият интелект определено е тема, по която си струва да сме предпазливи. Много тънка е границата между сериозните проекти, които определено могат да подобряват живота на всички ни, и пълните фалшификати, които пък създават предубеждения към цялото направление.

Когато представям различни Дигитални истории, свързани с изкуствения интелект, може би понякога се улисвам в предвиждането на едно прекалено оптимистично бъдеще. Темата го предполага. А и понякога този тип технологии изненадват изумително с напредъка си. Достатъчно е да спомена лицевото разпознаване, машинния превод, автономните коли.

Снимка: Dominik Scythe, Unsplash

И, И… какво?

Затова по такива теми се старая да представям балансирани истории, в които не прекалявам с оптимизма или скептицизма.

„Никога не инвестирайте в бизнес, който не разбирате“, казва Уорън Бъфет. И е факт, че опасността да ни изиграят понякога е много по-голяма, стане ли дума за модерните технологии. Достатъчно е да споменем митичната измама с блокчейн за милиарди OneCoin, тръгнала от България.

При изкуствения интелект за съжаление това също важи с пълна сила. На едро или пък съвсем на дребно, лепвайки толкова модерния етикет на всяка дреболия. Много е важно какво точно се крие зад определението „ИИ“ във всеки конкретен случай. Разбира се, важно е да вярваме в сериозното развитие на технологиите и да сме подготвени за бъдещето, което идва. Но все пак, добре е и винаги да имаме едно наум…