„Как изпуснахме обществения договор? Ей така, тихичко…“

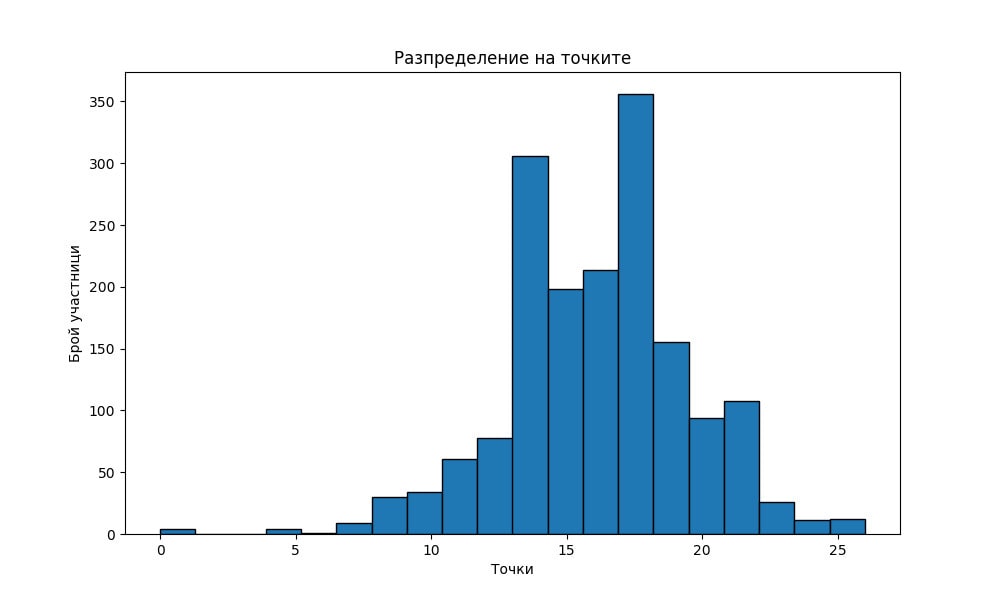

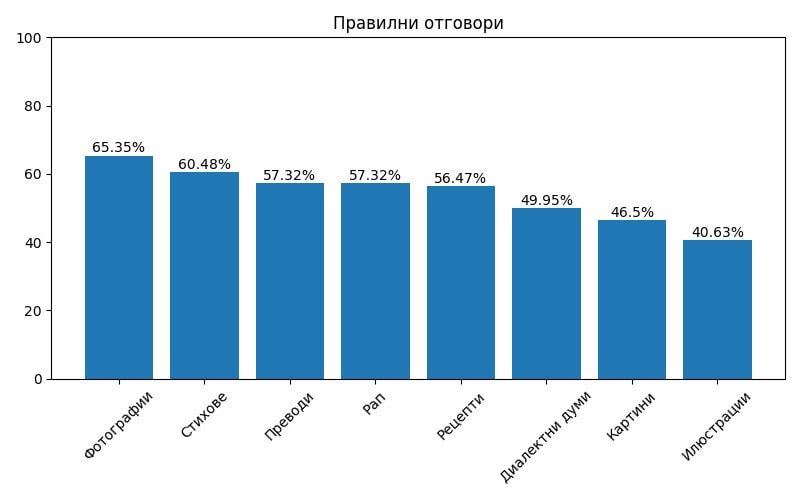

Вече не сме способни да различаваме текстовете и изображенията, генерирани от изкуствен интелект от тези, създадени от човека. Това е големият извод от експеримента на Дигитални истории, в който се включиха над 1800 души.

Тестът беше вдъхновен от сайта chovek.ai, създаден от Българския център за нестопанско право (БЦНП). Но защо… адвокати и правозащитници се вълнуват от тази толкова актуална тема? Както предстои да научим, те имат много важна гледна точка към промените, които ни носят технологиите.

Срещаме се с Надя Шабани, правозащитен адвокат и директор на БЦНП, и с Радина Банова-Стоева, правозащитен адвокат и правен консултант към центъра.

Какъв ще е начинът, по който оттук нататък ще можем да различаваме истината?

Защо е важно да си говорим за човешките права в контекста на големите въпроси, пред които днес ни изправят технологиите? Обречени ли са опитите за регулация на изкуствения интелект? Как да решим големия въпрос с етиката в тази област?

Защо решенията, които вземаме днес по въпросите на изкуствения интелект, имат толкова голямо значение за бъдещето на цивилизацията ни?

– Станаха ясни резултатите от експеримента на Дигитални истории, а той е продължение на вашия, в който незабавно виждаш дали си познал правилно – човек или изкуствен интелект е авторът. Кое ви накара да се насочите в тази посока, не е ли твърде далеч от правозащитната дейност?

– Надя: Още през 2020 г. направихме първия семинар за ИИ и права на човека. Тогава все още тези идеи звучаха изключително странно. Изглеждахме като рошави правозащитници, които се вълнуват от фантастични сюжети.

Още тогава, а и винаги сме смятали, че едно общество трябва да се модернизира. Технологиите помагат в процеса на тази модернизация, съдействат за борбата срещу неравенствата, дават възможности някои хора, иначе лишени от това, да имат по-добър достъп до знание и информация. Но нашата природа на правозащитници ни накара да започнем да мислим къде е точката, в която някой може да пострада от напредъка на тези технологии. И като почнахме да водим този разговор, видяхме, че няма как да сме конкретни.

Измислихме кампанията chovek.ai с колегите от Fine Acts – глобалното студио за социално въздействие. Те предложиха да минем през погледа към изкуството – поле, в което всеки мисли, че разбира, за да могат хората да видят как биха могли да да бъдат заблудени.

За нас най-важният извод остана, че

там, където е текстът, където са фактите, съжденията, ние, хората, сме много по-неподготвени да разпознаем кое е вярното.

Правим подобен род кампании, за да провокираме мисленето. И когато видим, че някой се замисли и развие разговора, искрено се радваме. Твоят експеримент мина на следващо ниво и надгради, а това помогна да се замислим и върху други неща. Каква ще е онази подготовка, която да ни помага да разберем, кое ще е специфичното знание, което ще позволи на хората да отличават вярното от генерираното?

– Уви, за момента изглежда, че нямаме такова решение. Бяха ми писали, че е лесно, ако въведем четвъртия закон на роботиката. Роботът винаги да казва, че е робот, генерираното да е обозначено. Това няма как да стане, вече е много лесно такъв модел да бъде пуснат на обикновен компютър. Може би просто няма механизъм и трябва да се откажем от идеята, че можем да различаваме истината?

– Радина: Подобен е случаят с кликовете за бисквитките. За да пазим хората от събиране на информация за тяхното поведение, въведохме задължение потребителите да бъдат уведомявани какви бисквитки действат и на какви доставчици се предоставя събираната информация. Никой обаче не влиза да чете с какво се съгласява, а избира бързата опция „съгласен с всичко“. Аз съм единственият човек, когото познавам, който влиза и клика на всичко аналитично: „Не, не, не“.

Надя Шабани и Радина Банова-Стоева

– Така е, при това нарочно, да не е лесно да отказваш. Наистина, според мен GDPR е пример за неработещ регламент – тук обяснявам защо. Но ако се върнем на изкуствения интелект, много хора ми писаха – добре, видяхме експеримента с „хубавата“ Елена, но какво от това, че е изкуствена, защо да има значение?

– Надя: В случая нищо, наистина, харесало ни е и толкова… Обаче има ситуации, в които може да има огромно значение. Ето, идват европейски избори, да си представим: една политическа партия обявява някаква програма и изкуствен интелект генерира анализ, който на пръв поглед е много обоснован, но спекулативно комбинира тенденциите. И с това навежда на мисли гласоподавателите, прави конкретни внушения.

Ако авторът е изследовател, ако се е подписал и прави неверни твърдения, след това може да му бъде потърсена отговорност, включително и съдебна.

Радина: Въпросът тук е, че

често е неустановимо кой е този, който стои отзад, от кого можеш да потърсиш отговорност?

Ако вземем ChatGPT, в техните Общи условия е ясно посочено чия е отговорността. Правя хипотеза, че тези Общи условия също никой не ги чете и всеки се съгласява набързо, а в тях изрично е казано: „Отговорността е твоя!“. Влизаш и използваш на свой собствен риск. Оттам нататък се оправяй. Тук възниква въпросът за невъзможността да се търси отговорност, независимо може ли или не да се установи спрямо кого, защото човекът е изразил изрично съгласие.

Надя: Ние сме щастливци, че всяко поколение преживява голям технологичен прогрес. Изкуственият интелект обаче е много по-различен от всички други технологии, които ти дават предимство, скъсяват време, обработват данни, които иначе отнемат огромни количества човекочасове. ИИ сам „взима“ решения, но без да я има отговорността. Аз си представям, че скоро ще е много популярен изкуствен интелект, който прави медицинска консултация. Ще е обучен на много богати данни, ще има опита на милиони лекари, ще познава огромен брой казуси. Но това достатъчно ли е, за да повярваш и да се лекуваш?

– Този проблем – именно за отговорността, се появява в толкова много посоки. Например преводачите. Алгоритъмът понякога превежда неразличимо от човека, но кой носи отговорността, ако в преведеното указание на лекарството пише нещо опасно?

– Това е първо – отговорността, защото правото не може да измисли рамка, в която ние никога да не бъдем ощетените. То измисля рамка, в която, ако някой е ощетен, да може да потърси възмездие.

В случая един от грандиозните проблеми е „извинете, ако стане беля, си е за ваша сметка“.

Така влизаме в някакъв дарвинизъм! Който оцелее, оцелее.

Който не – да се оправя. Това за нас, правозащитниците, е голям проблем. Ясно е, че не искаме да спираме прогреса, просто искаме да го осмислим по-добре, всички засегнати страни да участват в този процес, за да не си причиняваме грешките, от вече които сме страдали.

Не искам да обвинявам технологичните компании, които го развиват. Нашият спор не е с технологията. Той може би е с общността, която я развива – понякога там има етични стандарти, но те не могат да ни гарантират всички важни отговори.

Макар наистина да прилича неотличимо на стила на Йеронимус Бош, и тази картина е създадена от алгоритмите. Това обаче обърка цели 88,7% от включилите се в експеримента на Дигитални истории.

– Именно заради това, заради предизвикателства от този тип, за които трябва да си говорим всички, хора от всяка една област, го има и този сайт.

– Радина: И е чудесно да срещнеш друг човек, общност, организация, които споделят това разбиране: представяне на значими теми по достъпен и разбираме за всеки начин, с елемент на предизвикателство, за да се открие поле за диалог.

Що касае етичните стандарти, колкото и и споразумения за надежден ИИ да се подпишат, те са и винаги ще бъдат пожелателни.

От една страна, винаги стигаме до отговорността, а тя може да гарантира човешки права само ако в един буквален, физически контекст може да поставим нещо, което не е физическо. Или както европейските институции формулират принципа за регулация на ИИ: „Всичко, което е забранено офлайн, е забранено и онлайн“.

Другият голям проблем е с отделния човек. ИИ може да помага, например, в казуса на Брус Уилис, който е със сериозно заболяване и тези технологии правят възможно образът му да води „свой живот“. Но в случаи на политически фигури, активисти или други публични личности, чиито животи се опропастяват заради deep fake видео, се демонстрират големите проблеми, които ИИ технологиите могат да създадат. Тези два варианта касаят обаче индивидуални съдби. Ако говорим за големите процеси,

трябва да си отговорим на въпроса: колко ни е важна истината?

Защото политическият процес, демокрацията и гражданското участие се крепят на истина. Ако сме съгласни всеки следващ ден да се будим в среда, която не познаваме, няма проблем…

Надя: За някои процеси истината е същностна и когато направим промяна там, не можем просто да разчитаме на критичното мислене на хората да си я търсят сами. Това дискредитира целия процес и отговорността.

Нещо важно са и социалните неравенства. Според мен трябва да ги обмисляме и с оглед на приложенията на изкуствения интелект. Първо са тренировъчните данни, на които се обучават алгоритмите. Според мен трябва да има стандарти и сертифициране в тази посока – за какви приложения какви данни да се ползват. Иначе кашата става голяма и от нея автоматично се генерират неравенства.

Има два фактора, които ще определят кой ще ползва с предимство и това ще отвори огромна ножица.

Младите и хората с пари автоматично ще се окажат в по-силна позиция.

– Но пък Бил Гейтс каза че ИИ е революция, точно защото повече хора ще имат достъп до здравеопазване и образование. Изведнъж в цяла Африка ще има нещо, подобно на лекар, на достъпен лаптоп.

– Дали това е проблемът?

Малко ми прилича на тезата – отиваме в третия свят, взимаме им петрола и природните богатства, даваме им пари

да им направим улицата и училището, и на правителството даваме пари. Но там няма демокрация. Това не е наша тема, взимаме си петрола, тръгваме си и потопът е голям.

Видяхме социалните мрежи. Те дадоха огромно предимство на някои хора в тези държави да споделят своя глас, но доведоха и до много злоупотреби. Не е толкова просто.

Това не е само търговски продукт, технология, а е нова ситуация, в която ще живеем и работим.

– Така мисля и аз. И този път можем да си дадем сметка, за разлика от прехода към социалните медии. В началото на 2000-те не предполагахме, че битката ще е за истината и ние, журналистите, ще я загубим толкова безславно във фийда. Но как да убедим хората обратно, че това е важно за тях – кой и защо го пише, защо е важна истината?

– Аз не обвинявам хората, мисля, че

социалните мрежи са проблем, който изисква, както и ИИ, един публичен консенсус, който трябва да е част от обществения договор.

Да наложим да се промени нещо, защото не е решение да оставим всичко на личната самокритичност.

По времето на ковид се стрясках как хора, които познавам, в резултат на социалните мрежи, стигнаха до крайности, очевидни лъжи. Не мога да кажа, че са глупави или некритични. Мисля, че обработването в и през социалните мрежи е метод, който, освен че е пропаганден и манипулативен, е тотално измамен. Правото регулира и измамата, само че тук още не сме го регулирали. Първоначално се ядосвах на разни хора, защо споделят това или онова. Но сега смятам, че

както много хора стават жертва на измамници, така те са жертва на това, което се случва в социалните мрежи, на манипулациите.

– Само че ние вече не можем да регулираме случващото се, защото е в ръцете на компании, които са по-големи и силни от държавите, от обединенията.

– Това е проблемът! Как изпуснахме обществения договор? Ей така, тихичко…

И мен ме притеснява този въпрос. Трябва да има разговори, консенсус, но дали наистина тези, които взимат решенията, участват в този разговор? Според мен трябва да намерим начин да ги накараме да се включат.

Ние по природа, като активисти, трябва да сме позитивни, да вярваме в доброто, в хората. Но аз смятам, че ще изживеем отново човешки трагедии и чак тогава ще научим нашите уроци.

Радина: Ако обърнем поглед към регулацията като потенциално решение можем да погледнем първо GDPR – това е пример за много късна регулация на едни големи проблеми, който констатирахме впоследствие. Регулация впоследствие не е невъзможна, дали ще послужи, е друг въпрос. Ще видим прословутия акт за ИИ, какво точно ще е официалното му съдържание, което ще разберем може би този април, какво ще стане, какъв ще е крайният резултат?

Когато започнахме да се занимаваме с темата за ИИ, и ние извървяхме дълъг път до днес. В началото и аз също се ужасявах на момент какво ще стане… Но колкото повече навлизам в темата, си давам сметка, че ИИ е инструмент, а не самостоятелен интелект. Мислейки за него през метафорите и аналогиите, върху които е създадена терминологията за ИИ, е нормално да се стигне и до страх: ИИ се гради върху „невронни мрежи“, „халюцинира“, той е „интелект“. Ако го допуснем по-близо до себе си и го опознаем, можем да придобием контрол над него, както и при всяка предходна технологична революция.

Аз не знам дали имам вяра в хората, обаче имам вяра в това, което хора като нас и като теб правят.

– Къде е важно да върнем и запазим истината?

– Надя: В политиката, демократичните процеси. Според мен правораздаването също е чувствителна сфера. Да, би било добре да има различни автоматизирани системи, които да помагат правосъдието, но там водеща си остава преценката. Субективният елемент, който е свързан единствено и само с конкретната ситуация, нищо, че тя наподобява на милион други.

– А може би алгоритмите именно там могат да са по-обективни от нас?

– Радина: Смятам, че е логично да се насочим към регулация, която да казва докъде е границата. За всяко нещо, което касае човешка съдба, а правораздаването е най-силен пример, не може да се позволи изкуствен интелект да взима крайни решения. Тук трябва да има човешка преценка накрая.

Надя: Според мен са сферите, където съвестта има основно значение, а не толкова знанието. В правораздаването това е съвестта на съдията.

Приложимо е обаче не само в правораздаването. Нека си представим двама родители, които ползват някаква апликация, която да дава съвети за отглеждане на дете. Може ли да се доверим напълно? Според мен не. Всеки дава съвети, но ти преценяваш кое е най-добро за детето ти.

Човешкото дете расте в отношения и привързаност, а не от най-доброто знание.

Затова там, където водещи са съвест, личност, с цялата уникалност на всяко човешко същество, е важно да пазим човешкото. Другото е вторично.

– А изкуството? Може ли да го дадем на алгоритмите?

– Аз също съм се чудила много по този въпрос и даже съм си променяла мнението. Сега съм на вълната, че трябва да е забранено да се използва ИИ. В изкуството кое е онова, което ни кара да изпитваме удовлетворение? Не само красотата, независимо дали е език, изображение, или нещо друго, а и

усещането, че друго човешко същество ни изпраща някакво послание.

Аз също харесвам природата, но усещането, когато виждам красива природна гледка, е съвсем различно от това на произведение на изкуството, нещо, създадено от друг човек, който ми изпраща посланието си.

Едва 483 участници или 28,7% познаха, че това е илюстрация, създадена от ИИ, а не от художничката Мая Бочева – Уики

– Изглежда, обаче, вече може да бъде неразличимо. Новите технологии променят и нашата памет, например историята. И пак стигаме до истината. Как да я валидираме днес?

– Според мен сме достатъчно креативни.

След като човекът е измислил изкуствения интелект, все ще измисли и как да го регулира.

Въпросът е как, независимо от това колко пари се печелят от такива технологии, да държим на правилата. Да поставим правилата пред парите.

Радина: Смятам, че можем да се опрем на една базова човешка потребност: тази от сигурност. В стрес не можеш да изпитваш сигурност. А голям източник на стрес е незнанието, неяснотата какво ще стане утре, кое е истина. Тук намирам и някакво успокоение, че хората ще имат мотивация да си търсят способи за проверка на информацията, естествено ще се развива необходимостта от изграждане на умение за критичен поглед над информацията, умения за търсене на източници и проверка на това, което на екрана изглежда като „факт“.

Фотография на Димитър Караниколов или „творение“ на изкуствения интелект? Четете тук.

– Много хора във фейсбук функционират в спокойствие, без да знаят.

– Така изглежда, нали?! Важно е обаче да уточним, че все в някакъв момент от деня хората напускат фейсбук, влизат в реалния свят, комуникират с други човешки същества – има все някакъв поток. А и фейсбук все пак дава възможност отделни хора да си изразят мнението – тяхната истина за нещата. Ако обаче целият поток от информация се генерира от нещо, което не можеш да провериш, не можеш да разбереш как е създало точно този текст, тогава ще се получи истинската несигурност. Какви личности ще израстват в подобна среда? Как ли ще се променят човешките отношения? Ако целият базов труд се поеме от изкуствен интелект, много хора ще останат без съзидателна дейност, каквато е трудът. Как ли ще следва наново да се осмислят те?

Не смятам, че трябва да минаваме в плоскостта добро ли е или лошо всяко потенциално развитие. Да оценяваме и миналото през тези категории е ненужно и неефективно. Много по-съществено е да си отговорим на въпроса как да уредим възможните последствия, които масовото внедряване на ИИ би имало.

А какво можем да правим днес за самите хора? Да им помагаме да се учат на нови умения.И може да се започне с много прости примери: „Потърси поне три източника, за да потвърдиш това факт ли е. Сподели с някого,направи поне едно сравнение с информация от другаде и чак тогава го сподели“. Подобни малки стъпки няма да решат проблема, но със сигурност ще помогнат. И ако се върнем към темата за отговорността, като правозащитници е важно да кажем, че

първа линия в защитата на човешките права е винаги самият човек.

– Така е. И аз мисля, че най-важното е да не се отказваме от разговора, от замислянето, осмислянето… Дано само да не е късно. Благодаря ви за този разговор!